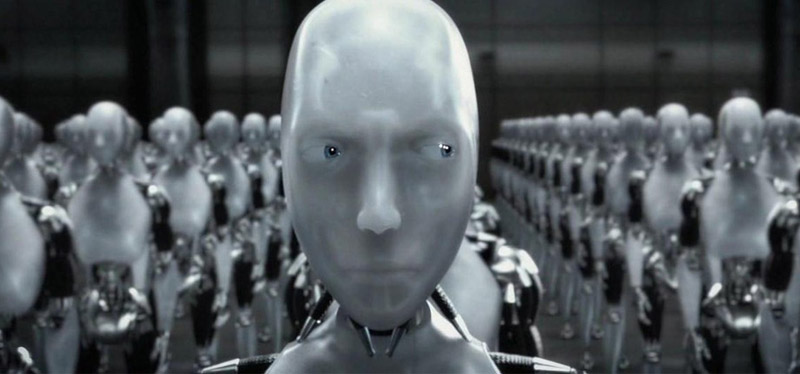

Inteligencia Artificial: ¿Por qué los científicos le dicen NO a los robots asesinos?

Un tema que tomó relevancia esta semana por el contundente rechazado de la comunidad científica a los adelantos tecnológicos que apuntan a la creación de robots asesinos. Conoce más sobre el tema, aquí.

Si bien aún estamos lejos de convivir con Androides tipo Eva, de la película de ciencia ficción ‘Ex Machina’ o la robot Vicky de la recordada serie ‘La pequeña maravilla’, sí estamos muy cerca de presenciar la aparición de verdaderas máquinas asesinas que podrían en grande riesgo a la humanidad entera.

Es por ello que científicos, entre investigadores y académicos, destacándose personalidades como Elon Musk y el astrofísico Stephen Hawking, han expresado su total rechazo a los adelantos que tienen como fin la creación de los denominados robots asesinos, mediante una carta enviada a las Naciones Unidas.

Lee también: Empleo vulnerable: Los desafíos impuestos por la inteligencia artificial

Justificaciones

Pero por qué la comunidad científica se opone al desarrollo de armas de inteligencia artificial. En este post queremos resumir algunos de los puntos que ellos exponen a fin de que tú, querido lector, forme su propia consideración frente a este tema que comienza a tener mayor relevancia en la opinión pública internacional.

Pues bien, primero debemos anotar que estos robots asesinos provienen de los adelantos de las llamadas armas autónomas, que no son otra cosa que tecnologías destinadas y programadas para matar y, esto es lo más alarmante, sin intervención humana.

Según anotaron los científicos las armas autónomas han sido descritas como la tercera revolución en la guerra, luego de la pólvora y las armas nucleares. “Hay mucho en juego, sobre todo porque una carrera mundial de armamento de este tipo es virtualmente inevitable si cualquiera de las grandes potencias militares sigue adelante con el desarrollo de armas de inteligencia artificial (IA)”, indicó el grupo en una carta abierta presentada en la Conferencias Internacional Conjunta de Inteligencia Artificial desarrollada en Buenos Aires.

Tiempos

De acuerdo a la manifestación del grupo científico estas armas autónomas estarían a la vuelta de esquina, pues tal y como señala la carta, “algunos sistemas de armas son factibles dentro de unos años, no décadas”.

“Las armas autónomas son ideales para tareas tales como asesinatos, desestabilización de naciones, represión de habitantes y exterminio selectivo de grupos étnicos, por lo que creemos que una carrera militar con armas de IA no sería beneficiosa para la humanidad”, apunta la misiva.

Toby Walsh, profesor de Inteligencia Artificial de la Universidad de New South Wales de Australia, es uno de los firmantes e indica que la diferencia entre las armas autónomas y los drones, que están siendo utilizados en Irak con armas, radica en que las primeras no hay un ser humano que intervenga en el proceso.

“En estos casos tenemos un soldado con un control remoto manejado un dron, pero él es quiem decide si matar o no matar. En cambio, en las armas autónomas es la computadora quien tomará decisiones de vida o muerte, lo cual implica cruzar un límite moral”, destacó.

Cabe indicar que actualmente las guerras de alta tecnología se libran mediante máquinas a control remoto. Por ejemplo, el ejército de los Estados Unidos posee un vehículo llamado MADSS, un rover de 635 kilos que lleva equipo y dispara con una ametralladora. Sin embargo, ya existen países que están experimentando con armas de IA, como es el caso de Israel que posee un “Iron Dome”, encargado de detectar y derribar cohetes entrantes.

Otras personalidades del mundo de la tecnología, entre miles de investigadores, profesores y científicos, como Steve Wozniak y el CEO de Google DeepMind, Demis Hassabis, también firmaron el documento.