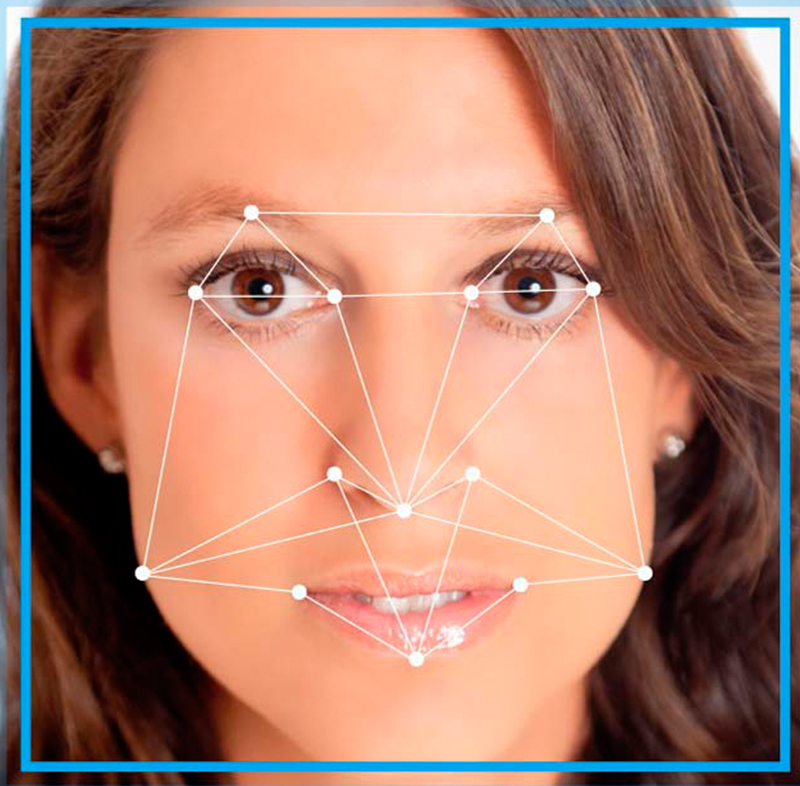

O Google apresentou detalhes da sua nova API para reconhecimento facial.

O recurso está disponível para desenvolvedores que queiram construir aplicativos capazes de dar respostas ao usuário por reconhecimento de gestos e expressões do seu rosto. Face API é a última atualização do Google Play Services (7.8) e permite detectar por detalhes faciais ou gestos do rosto quem está à frente do smartphone.

Assim, é possível desenvolver apps que possam responder a sorrisos, piscar de olhos ou expressões faciais para desbloquear, bloquear ou mesmo acionar determinados serviços/respostas, como abrir a câmera ou determinado aplicativo.

Com isso, as possibilidades de interação entre homem e máquina aumentam e está dada a largada para a criação de serviços automatizados.

Em substituição ao antigo Android FaceDetector, Face Detection API. Ela não reconhece o rosto do usuário, apenas é capaz de detectar se é ou não o rosto da pessoa com permissões de uso que está com o celular em mãos. A nova API detecta o rosto mesmo que esteja em inclinações diferentes da usual no smartphone.

O recurso não chega a ser uma novidade, mas a melhora da API, sim, que agora conta com poder de detecção mesmo dos rostos quando em diferentes inclinações.

Ela reconhece o lugar da boca, olhos, bochechas, orelhas e nariz e é capaz de responder se a pessoa da foto, vídeo ou streaming está ou não sorrindo, de olhos abertos ou fechados etc. E a partir daí, os apps podem ser capazes de detectar gestos, ampliando as possibilidades de uso da tecnologia.

As portas que se abrem são muitas, como comandar a câmera para que tire foto quando todos estejam sorrindo ou a criação de um emoji de beijo quando o usuário mandar um beijo para a câmera do smartphone.

Desta forma o Google pretende fazer do reconhecimento facial, um leitor de sentimentos. Porém, se tomamos como exemplo o vídeo demonstração, as expressões ainda parecem forçadas demais para poderem ser reconhecidas com naturalidade.

Outro recurso melhorado é a detecção de código de barras: Barcode API. Mais uma vez, os smartphones já faziam isso, mas de forma limitada. A atualização da API permite a identificação dos códigos independentemente da posição em que estejam, em tempo real e mais de um código por vez.

Na mesma linha da última atualização do Face Detector do Google, encontramos um serviço apresentado no TEDWomen 2015: Emotion Engine, de autoria da egípcia Rana el Kaliouby, que pretende trazer à tona nossas emoções para uso nos dispositivos eletrônicos.

Considerando que hoje em dia passamos mais tempo do nosso dia com nossos smartphones ou PCs, como fazer para que os dispositivos pudessem interagir e saber mais como nós nos sentimos? A ideia era permitir respostas das máquinas de acordo com nossas expressões.

Tudo começou por inquietação de Rana que via os aparatos eletrônicos com alta inteligência cognitiva, mas nenhuma inteligência emocional que pudesse traduzir com fidelidade o que se passava com a pessoa por trás da máquina.

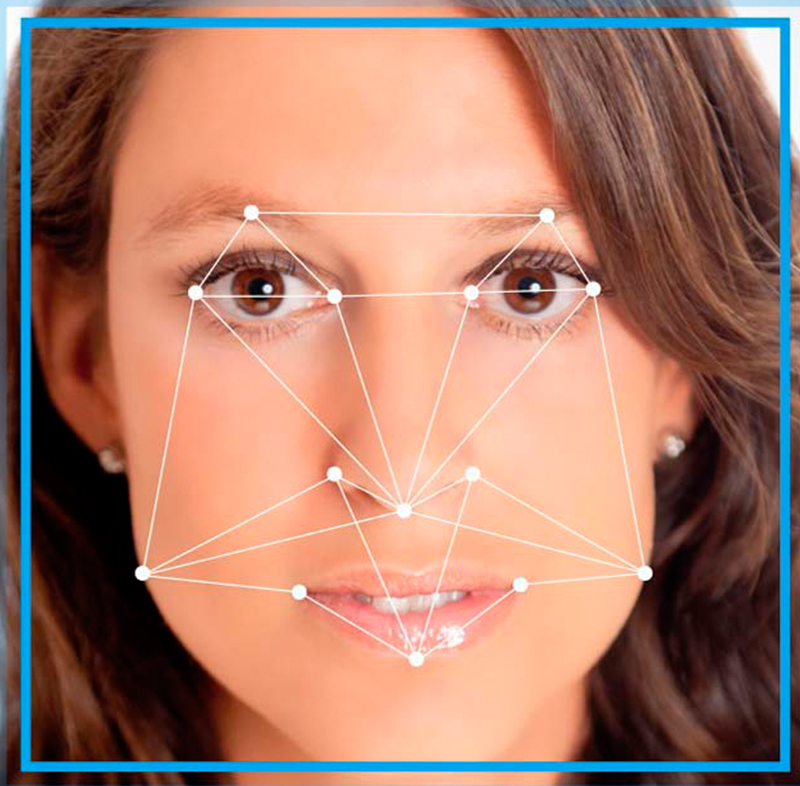

O passo seguinte seria fazer com que as máquinas fossem capazes de dar respostas a estes sentimentos detectados: alegria, surpresa, medo, empatia, curiosidade etc. E os caminhos já estavam prontos, na ciência da emoção, as unidades de ação são conhecidas e mapeadas a partir de cada movimento muscular facial. Por exemplo, a “unidade de ação 12” consiste no levantar dos cantos do lábio, principal componente do sorriso (você pode parar e testar agora).

São aproximadamente 45 unidades de ação que se combinam para exprimir centenas de sentimentos e emoções. Como são combinadas e às vezes de movimentos rápidos demais, é difícil ensinar um computador a reconhecê-las. Como permitir a diferenciação entre um sorriso de alegria e um sorriso sarcástico?

Por meio de exemplos. Assim, com milhares de dezenas de exemplos do que seria um sorriso de alegria, misturando pessoas de diferentes etnias, idades e sexo sorrindo, é possível ensinar uma máquina a reconhecê-lo com precisão.

Desta maneira, uma ideia dentro do MIT há cinco anos se tornou uma empresa, com um banco de dados de milhões de expressões de pessoas de 75 países diferentes. Os resultados do estudo são muito legais e mostram também um pouco da diferença expressiva entre homens e mulheres.

Mais que respostas, o software pode ser útil para diversas outras situações. Estamos nos expressando e sentindo emoções quando escrevemos um e-mail, acompanhamos a timeline do Facebook, quando compramos algo online ou preenchemos fichas e cadastros.

Os usos são muitos e estão aí para testes. Por exemplo, acelerar uma lição educacional, caso o estudante esteja aborrecido, ou explicar melhor em caso de reconhecimento de dúvida; auxiliar uma pessoa autista a decifrar emoções; os carros poderiam descobrir se estamos cansados demais para dirigir; ou uma geladeira poderia não abrir caso reconhecesse ansiedade que poderia desencadear uma comilança desenfreada.

Vai chegar o dia em que todos os produtos virão com chips emocionais. E aquela velha máxima de que a tecnologia nos afasta dos nossos sentimentos será coisa do passado.

"Golpe do @", o novo golpe descoberto com o dfndr security já tem mais de…

Empresa foi convidada a colaborar na construção do relatório “O impacto e futuro da Inteligência…

Conheça o novo golpe que se aproveita do maior evento esportivo do mundo

Modalidade de phishing se tornou a campeã de detecções em 2022, acumulando mais de 5…

Golpe do Auxílio, criminosos estão utilizando indevidamente o nome do programa e prometem transferência em…

Presente nas principais redes sociais, perfis do ‘Robô do PIX’ induzem pessoas a acessarem links…